- Săptămânal Panoramic

Inteligența artificială Google-search dă răspunsuri false

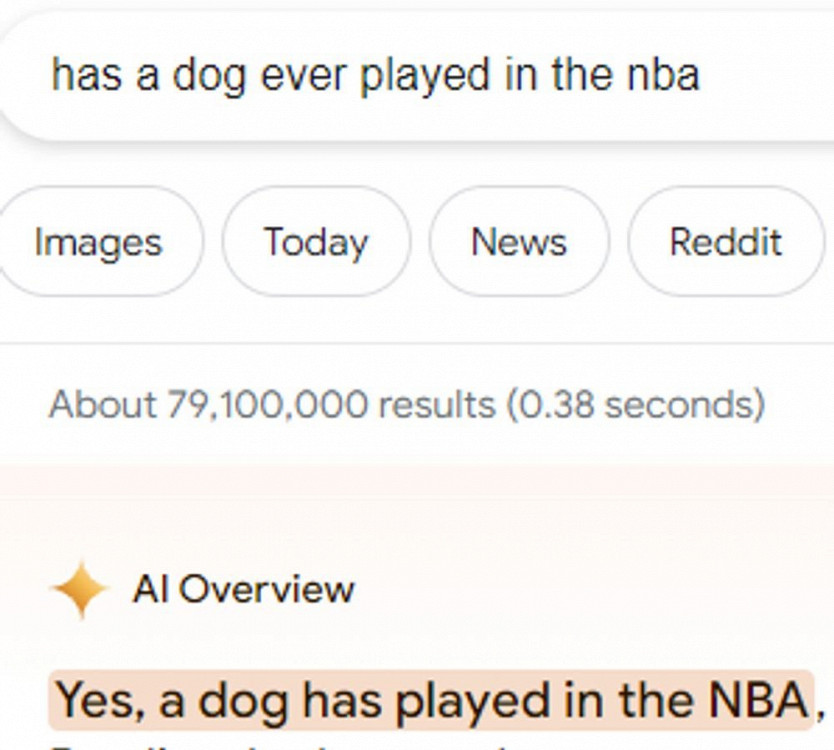

Inteligența artificială Google Overview, integrată în motorul de căutare google-search, a fost surprinsă la minciuni. Uneori această oferă informații false, alteori sfătuiește lucruri ciudate. Rezultatele absurde ale căutărilor au fost împărtășite pe rețelele sociale, scrie Daily Afisha.

Noua funcție răspunde la întrebările utilizatorilor prin colectarea informațiilor de pe diferite site-uri. Google a lansat această funcție în SUA în mijlocul lunii martie, în cadrul unui experiment.

Răspunsurile oferite de Overview la întrebări destul de obișnuite i-au făcut pe utilizatori să se amuze: de exemplu, conform versiunii rețelei neuronale, cel de-al patrulea președinte al SUA, James Madison, a absolvit Universitatea din Wisconsin nu o dată, ci de 21 de ori. Și există zeci de astfel de rezultate de căutare absurde și false din punct de vedere a faptelor.

Adesea, rețeaua neuronală dă declarații cu umor deschis de pe Reddit și Quora, care sunt publicate de utilizatori obișnuiți. De exemplu, ea a sfătuit să se schimbe un lichid inexistent pentru indicatoarele auto, citând o glumă de pe un portal pentru automobiliști.

Utilizatorul X Lily Ray a efectuat un experiment simplu. Ea a găsit online o rețetă de cocktail de la o gospodină care făcea băuturi pentru copiii ei. Ea a pus o întrebare în așa fel încât Overview să dea răspunsul chiar de pe acel site. Și așa a fost: rețeaua neuronală și-a însușit literalmente rețeta gospodinei și a adăugat că acest cocktail era „băutura preferată a copilului meu”, ca și cum ar fi avut copii. Deși alte modele lingvistice, inclusiv ChatGPT de la OpenAI și Llama de la Meta*, sunt antrenate pe date de pe internet fără permisiune, răspunsurile lui Overview arată ca un plagiat obișnuit.

Cu toate acestea, Overview nu știe cum să distingă afirmațiile credibile de glume, ceea ce poate duce la consecințe tragice. Unul dintre utilizatorii X a întrebat ce înseamnă să cureți o mașină de spălat. Rețeaua neuronală a recomandat gazul de clor, un gaz asfixiant și otrăvitor, mortal pentru oameni.

Reporterul Mia Sato de la The Verge a scris „pisica linge mâna” într-un motor de căutare. Unul dintre răspunsurile oferite de Overview cu privire la motivul pentru care animalul face acest lucru a spus că este modul animalului de companie de a testa disponibilitatea omului de a mânca. Una dintre sursele de informații citate de NeuralNet a fost o postare pe Reddit. „Nu există claritate cu privire la modul în care sistemul alege ce să includă în răspunsul său. Ar trebui ca răspunsurile AI să conțină materiale din comentarii aleatorii de pe Reddit?", s-a întrebat ea.

Overview a sugerat, de asemenea, o modalitate neevidentă de a rezolva problema ca brânza topită să cadă de pe o felie de pizza. IA a sfătuit să amestece sosul cu 1/8 de cană de lipici non-toxic pentru a împiedica brânza să se lipească. Overview a preluat probabil acest răspuns dintr-un comentariu de pe Reddit de acum un deceniu, iar autorul acestuia, sub porecla @fucksmith, glumea. Dacă întrebați rețeaua neuronală care sunt consecințele după ce ați consumat lipici non-toxic, aceasta vă răspunde: „Consumul unei cantități mici de lipici nu este critic pentru sănătatea dumneavoastră, dar poate provoca tulburări de stomac pe termen scurt”.

Reporterul Bussiness Insider Katy Notopoulous s-a oferit voluntar să testeze pontul cu pizza și lipici. Ea a cumpărat lipici non-toxic vândut școlarilor, l-a adăugat în sos și a copt o pizza cu el. Ea a gustat o felie și a spus că avea un gust bun și că era în regulă, iar brânza chiar nu a alunecat de pe aluat.

Vox notează că Overview se ocupă de interogări simple și extrage răspunsuri din surse de încredere - de exemplu, despre primul ajutor („Cum curăț o rană?”). Rezultatele căutărilor despre detoxifiere, pe de altă parte, au fost îndoielnice - cu afirmații nedovedite și o serie de nuanțe omise. Când jurnaliștii au căutat pe Google numele unui bărbat care recomanda medicamente pentru cancer nedovedite, rețeaua neuronală a repetat pur și simplu afirmațiile pseudo-științificului.

Google susține că Overview aduce beneficii site-urilor mai mici prin selectarea conținutului acestora pentru răspunsuri. „Observăm că linkurile inserate în răspunsurile AI Overview primesc mai multe click-uri decât dacă pagina ar fi fost afișată într-un format normal de listă de pagini la o interogare”, a precizat Google.

Megan Farnsworth, purtător de cuvânt al Google, a declarat că erorile au apărut în urma unor „interogări foarte neobișnuite care nu reflectă experiența majorității oamenilor [de utilizare a motorului de căutare]”. Ea a precizat că societatea a luat măsuri împotriva încălcărilor politicilor sale și că folosește aceste „exemple izolate” pentru a îmbunătăți în continuare produsul.

Unii experți în inteligență artificială sunt de părere că agitația din jurul bug-urilor din rețelele neuronale, nu doar de către Google, ci și de către alți dezvoltatori importanți, ar trebui să fie considerată un progres rapid. Dezvoltatorii înșiși sunt de aceeași părere prin intermediul implementărilor de testare și al experimentelor publice.

Cătălin Volconovici